Mục lục [Ẩn]

- 1. Data Integration là gì?

- 2. Cách thức hoạt động của Data Integration

- 3. Các thành phần chính của tích hợp dữ liệu

- 4. Các phương pháp Data Integration

- 4.1. Sao chép dữ liệu

- 4.2. Liên kết dữ liệu

- 4.3. Ảo hóa dữ liệu

- 4.4. Hợp nhất dữ liệu

- 5. Vì sao doanh nghiệp cần triển khai Data Integration?

- 6. Quy trình triển khai Data Integration trong doanh nghiệp

- 6.1. Xác định yêu cầu và mục tiêu kinh doanh

- 6.2. Khảo sát nguồn dữ liệu và hạ tầng

- 6.3. Thiết kế kiến trúc và lựa chọn công cụ

- 6.4. Phát triển và cấu hình (Implementation)

- 6.5. Kiểm thử và Triển khai (Testing & Deployment)

- 6.6. Giám sát và Bảo trì (Monitoring)

- 7. Thách thức khi triển khai Data Integration

Data Integration là chìa khóa để kết nối và quản lý dữ liệu từ nhiều nguồn khác nhau, giúp doanh nghiệp tối ưu hóa quy trình và ra quyết định nhanh chóng. Tuy nhiên, khi quy mô doanh nghiệp phát triển, việc tích hợp dữ liệu hiệu quả không phải là điều dễ dàng. Bài viết này sẽ giải quyết những thách thức lớn trong quá trình tích hợp và giúp doanh nghiệp cải thiện hiệu suất làm việc, giảm thiểu chi phí và tăng trưởng bền vững.

Nội dung chính bài viết:

Data Integration (Tích hợp Dữ liệu) là một quá trình quan trọng trong quản lý dữ liệu, liên quan đến việc kết hợp và làm cho các dữ liệu không đồng nhất từ nhiều nguồn khác nhau trở nên thống nhất trong một hệ thống chung.

Quá trình tích hợp dữ liệu gồm từ việc xác định nguồn dữ liệu, trích xuất, chuyển đổi cho đến tải dữ liệu vào hệ thống đích và đảm bảo chất lượng.

Các phương pháp Data Integration phổ biến: Sao chép dữ liệu; Liên kết dữ liệu; Ảo hóa dữ liệu; Hợp nhất dữ liệu

Data Integration mang lại cái nhìn thống nhất và chi tiết về hoạt động kinh doanh, mà còn giúp cải thiện quyết định, tối ưu hóa quy trình, và tăng trưởng bền vững.

Quy trình triển khai Data Integration trong doanh nghiệp là một chuỗi các bước quan trọng nhằm kết nối và hợp nhất dữ liệu từ nhiều nguồn khác nhau vào một hệ thống duy nhất

1. Data Integration là gì?

Data Integration (Tích hợp Dữ liệu) là một quá trình quan trọng trong quản lý dữ liệu, liên quan đến việc kết hợp và làm cho các dữ liệu không đồng nhất từ nhiều nguồn khác nhau trở nên thống nhất trong một hệ thống chung. Mục đích chính của tích hợp dữ liệu là cung cấp cho người dùng một cái nhìn tổng thể, chi tiết và dễ hiểu về dữ liệu, cho phép thực hiện các tác vụ truy vấn và phân tích dữ liệu một cách hiệu quả.

Quá trình này giúp kết nối các hệ thống dữ liệu có cấu trúc khác nhau, chẳng hạn như cơ sở dữ liệu, bảng tính, hoặc hệ thống quản lý doanh nghiệp, vào trong một lược đồ duy nhất, đồng nhất. Data Integration cung cấp khả năng hiển thị và sử dụng dữ liệu từ các nguồn khác nhau mà không cần phải xử lý từng nguồn riêng biệt, giúp giảm thiểu sai sót và tăng hiệu quả trong công việc phân tích dữ liệu.

Quá trình này không chỉ là việc chuyển đổi dữ liệu từ một nguồn này sang một nguồn khác, mà còn bao gồm các kỹ thuật xử lý và làm sạch dữ liệu, đảm bảo rằng các dữ liệu được tích hợp có chất lượng cao và có thể sử dụng được trong các ứng dụng phân tích, báo cáo hoặc các quy trình tự động.

Trong bối cảnh ngày càng có nhiều doanh nghiệp chuyển sang sử dụng hệ thống điện toán đám mây và dữ liệu phân tán, Data Integration đóng vai trò quan trọng trong việc tự động hóa quy trình kinh doanh. Các doanh nghiệp cần phải xử lý, lưu trữ và phân tích một lượng dữ liệu khổng lồ từ nhiều nguồn khác nhau để đưa ra những quyết định thông minh và nhanh chóng.

Việc sử dụng các nền tảng tích hợp dữ liệu giúp cải thiện tính khả dụng và độ tin cậy của dữ liệu, đồng thời nâng cao hiệu quả hoạt động của tổ chức. Bằng cách tích hợp dữ liệu, doanh nghiệp có thể xây dựng một cái nhìn toàn diện về khách hàng, cải thiện quy trình hoạt động, tối ưu hóa chiến lược marketing, và ra quyết định kinh doanh dựa trên dữ liệu chính xác và đáng tin cậy.

2. Cách thức hoạt động của Data Integration

Data Integration (Tích hợp dữ liệu) là một quy trình phức tạp nhưng cực kỳ quan trọng trong việc kết nối và hợp nhất dữ liệu từ nhiều nguồn khác nhau thành một hệ thống duy nhất. Mục đích là tạo ra một cái nhìn thống nhất về dữ liệu, giúp doanh nghiệp đưa ra các quyết định chính xác và nhanh chóng.

Quá trình này bao gồm nhiều bước, từ việc xác định nguồn dữ liệu, trích xuất, chuyển đổi cho đến tải dữ liệu vào hệ thống đích và đảm bảo chất lượng.

1- Xác định nguồn dữ liệu (Data Source Identification)

Bước đầu tiên trong quá trình Data Integration là xác định các nguồn dữ liệu mà doanh nghiệp cần tích hợp. Các nguồn này có thể rất đa dạng, bao gồm cơ sở dữ liệu quan hệ, dữ liệu không cấu trúc từ các file Excel, dịch vụ đám mây, API, hay hệ thống kế thừa (legacy systems).

Mỗi nguồn dữ liệu này có thể chứa thông tin quan trọng nhưng lại có cấu trúc và định dạng khác nhau. Việc xác định và phân loại đúng các nguồn dữ liệu là bước đầu tiên và quan trọng để đảm bảo việc tích hợp diễn ra suôn sẻ.

- Chỉ rõ các nguồn dữ liệu chính mà doanh nghiệp sử dụng.

- Đảm bảo các nguồn dữ liệu có thể kết nối với nhau thông qua các công cụ tích hợp hoặc giao thức tương thích.

- Phân loại dữ liệu theo tính chất (cấu trúc, bán cấu trúc, không cấu trúc) để quyết định phương pháp tích hợp phù hợp.

2- Trích xuất dữ liệu (Data Extraction)

Sau khi xác định được các nguồn dữ liệu, bước tiếp theo là trích xuất dữ liệu từ các hệ thống này. Quá trình trích xuất dữ liệu có thể được thực hiện thông qua các công cụ tự động như truy vấn cơ sở dữ liệu, API, hoặc công cụ ETL (Extract, Transform, Load). Dữ liệu có thể đến từ nhiều hệ thống khác nhau, bao gồm cả các hệ thống lưu trữ đám mây hay hệ thống cũ của tổ chức.

- Trích xuất dữ liệu từ hệ thống nguồn mà không làm gián đoạn hoạt động của hệ thống.

- Đảm bảo rằng dữ liệu được trích xuất một cách chính xác và không bị mất mát trong quá trình chuyển giao.

- Sử dụng các công cụ hỗ trợ như SQL, API endpoints để trích xuất dữ liệu theo yêu cầu.

3- Lập bản đồ dữ liệu (Data Mapping)

Lập bản đồ dữ liệu là bước quan trọng trong quá trình tích hợp, nhằm xác định cách các yếu tố dữ liệu từ các hệ thống khác nhau tương ứng với nhau. Các nguồn dữ liệu khác nhau có thể sử dụng các thuật ngữ, mã số hoặc cấu trúc khác nhau để biểu diễn cùng một thông tin. Do đó, một bản đồ dữ liệu chi tiết sẽ giúp xác định và kết nối đúng các yếu tố dữ liệu này, đảm bảo tính nhất quán và đồng nhất.

- Xác định mối liên hệ giữa các trường dữ liệu từ các hệ thống khác nhau.

- Chuẩn hóa dữ liệu từ các nguồn khác nhau để có thể nhập vào hệ thống đích một cách đồng nhất.

- Lập bản đồ dữ liệu cho tất cả các trường cần thiết, từ đó đảm bảo quá trình tích hợp diễn ra chính xác.

4- Xác thực và kiểm tra chất lượng dữ liệu

Một bước quan trọng trong quy trình Data Integration là kiểm tra chất lượng dữ liệu để đảm bảo tính chính xác và toàn vẹn. Trước khi tiếp tục với các bước xử lý sau, dữ liệu phải được xác thực để phát hiện lỗi, sự không nhất quán hoặc các vấn đề về tính toàn vẹn. Kiểm tra chất lượng dữ liệu giúp đảm bảo rằng dữ liệu sau khi được tích hợp sẽ chính xác, đáng tin cậy và có thể sử dụng được cho các phân tích sau này.

- Phát hiện và sửa chữa các lỗi dữ liệu như thiếu dữ liệu, dữ liệu bị trùng lặp hoặc sai lệch.

- Đảm bảo tính toàn vẹn của dữ liệu qua các phương pháp như kiểm tra định dạng, so khớp dữ liệu giữa các nguồn.

- Áp dụng các công cụ kiểm tra tự động để giảm thiểu sai sót và đảm bảo chất lượng dữ liệu cao.

5- Chuyển đổi dữ liệu (Data Transformation)

Sau khi dữ liệu đã được trích xuất và kiểm tra chất lượng, bước tiếp theo là chuyển đổi dữ liệu (Data Transformation). Đây là giai đoạn dữ liệu được làm sạch, chuẩn hóa và làm giàu (enrichment) để phù hợp với hệ thống đích. Quá trình này bao gồm việc chuyển đổi dữ liệu từ các định dạng khác nhau sang định dạng chuẩn mà hệ thống đích có thể sử dụng.

- Chuẩn hóa dữ liệu về các đơn vị đo lường, đơn vị tiền tệ, hoặc các định dạng ngày tháng.

- Làm sạch dữ liệu để loại bỏ các giá trị thiếu, sai sót, và dữ liệu không hợp lệ.

- Làm giàu dữ liệu để bổ sung thêm thông tin cần thiết cho quá trình phân tích.

6- Tải dữ liệu (Data Loading)

Sau khi dữ liệu đã được chuyển đổi và chuẩn hóa, tải dữ liệu vào hệ thống đích là bước tiếp theo. Quá trình này có thể thực hiện theo hai hình thức: tải hàng loạt (batch loading) hoặc tải theo thời gian thực (real-time loading), tùy thuộc vào yêu cầu của doanh nghiệp. Việc tải dữ liệu vào hệ thống đích giúp dữ liệu trở thành thông tin có thể truy cập và phân tích.

- Tải dữ liệu vào kho dữ liệu (data warehouse) hoặc hệ thống phân tích.

- Chọn phương pháp tải dữ liệu phù hợp với yêu cầu về thời gian và tài nguyên hệ thống.

- Đảm bảo tính toàn vẹn và hiệu suất của hệ thống đích sau khi tải dữ liệu.

7- Đồng bộ hóa dữ liệu (Data Synchronization)

Để đảm bảo tính cập nhật và đồng bộ của dữ liệu, quá trình đồng bộ hóa dữ liệu là rất quan trọng. Việc đồng bộ hóa giúp đảm bảo rằng dữ liệu trong hệ thống đích luôn được cập nhật mới nhất và phản ánh chính xác dữ liệu từ các nguồn gốc. Đồng bộ hóa có thể được thực hiện theo thời gian thực hoặc định kỳ, tùy thuộc vào yêu cầu và tính chất của dữ liệu.

- Đảm bảo dữ liệu luôn đồng bộ và cập nhật mới nhất.

- Thiết lập lịch đồng bộ hóa dữ liệu để giảm thiểu sự trễ giữa các hệ thống.

- Sử dụng công cụ đồng bộ hóa tự động để duy trì sự chính xác và nhất quán của dữ liệu.

8- Quản lý dữ liệu và bảo mật (Data Governance and Security)

Trong quá trình tích hợp dữ liệu, quản lý dữ liệu và bảo mật là yếu tố cực kỳ quan trọng, đặc biệt khi xử lý dữ liệu nhạy cảm. Các tổ chức cần phải tuân thủ các quy định về quyền riêng tư và bảo mật khi xử lý dữ liệu, đảm bảo rằng dữ liệu được bảo vệ trong suốt quá trình tích hợp và lưu trữ. Các biện pháp bảo mật giúp ngăn chặn việc rò rỉ hoặc mất mát dữ liệu quan trọng.

- Tuân thủ các quy định bảo mật và quyền riêng tư khi xử lý dữ liệu.

- Áp dụng các phương pháp mã hóa và kiểm soát truy cập để bảo vệ dữ liệu trong suốt quá trình tích hợp.

- Đảm bảo tính bảo mật của hệ thống đích sau khi dữ liệu đã được tải vào.

9- Quản lý các siêu dữ liệu (Metadata Management)

Siêu dữ liệu là thông tin mô tả về dữ liệu tích hợp, giúp người sử dụng hiểu rõ hơn về cấu trúc và nguồn gốc của dữ liệu. Quản lý siêu dữ liệu đóng vai trò quan trọng trong việc tăng cường khả năng tìm kiếm và khai thác dữ liệu, giúp nhân viên dễ dàng tìm ra các dữ liệu cần thiết khi cần thiết.

- Quản lý siêu dữ liệu (Metadata) để dễ dàng truy xuất thông tin.

- Cung cấp thông tin rõ ràng về nguồn gốc và cấu trúc của dữ liệu.

- Tăng cường khả năng khai thác dữ liệu cho các mục đích phân tích và báo cáo.

10- Truy cập và phân tích dữ liệu (Data Access and Analysis)

Cuối cùng, sau khi dữ liệu đã được tích hợp, doanh nghiệp có thể sử dụng các công cụ phân tích và báo cáo để truy cập và khai thác dữ liệu. Các công cụ này giúp phân tích dữ liệu tích hợp, từ đó tạo ra các báo cáo hỗ trợ ra quyết định, giúp doanh nghiệp cải thiện hiệu suất và chiến lược kinh doanh.

- Sử dụng công cụ phân tích dữ liệu để khai thác thông tin từ dữ liệu tích hợp.

- Tạo báo cáo và phân tích trực quan giúp hỗ trợ ra quyết định kinh doanh.

- Áp dụng các công cụ phân tích tự động để cải thiện hiệu quả công việc và ra quyết định nhanh chóng.

3. Các thành phần chính của tích hợp dữ liệu

Quá trình tích hợp dữ liệu không chỉ bao gồm các bước kỹ thuật mà còn có nhiều thành phần quan trọng giúp kết hợp dữ liệu từ các nguồn khác nhau và tạo ra cái nhìn toàn diện, thống nhất. Các thành phần này đóng vai trò then chốt trong việc đảm bảo dữ liệu có thể được sử dụng một cách hiệu quả cho phân tích, ra quyết định và chiến lược kinh doanh.

- Nguồn dữ liệu (Data Sources): Các hệ thống hoặc dịch vụ cung cấp dữ liệu thô từ nhiều nguồn khác nhau. Chúng đóng vai trò quan trọng trong việc cung cấp dữ liệu cần thiết cho quá trình tích hợp, bao gồm cơ sở dữ liệu, tệp tin, API và các hệ thống đám mây.

- Dòng dữ liệu tự động (Automated Data Pipelines): Các quy trình tự động hóa luồng dữ liệu giúp di chuyển và xử lý dữ liệu một cách hiệu quả. Điều này giúp giảm thiểu sai sót và đảm bảo tính toàn vẹn dữ liệu trong suốt quá trình tích hợp.

- Giải pháp lưu trữ dữ liệu (Data Storage Solutions): Các kho lưu trữ dữ liệu như Data Warehouses và Data Lakes giúp lưu trữ dữ liệu có cấu trúc và không cấu trúc, tạo ra sự linh hoạt và hiệu quả trong việc truy cập và phân tích dữ liệu. Các nền tảng như Snowflake và PostgreSQL đóng vai trò quan trọng trong việc quản lý dữ liệu.

- Chuyển đổi dữ liệu (Data Transformation): Dữ liệu thô từ các nguồn khác nhau cần được chuẩn hóa và chuyển đổi thành định dạng đồng nhất để phục vụ cho phân tích và báo cáo. Quá trình này thường được thực hiện qua các công cụ như DBT (Data Build Tool), giúp tối ưu hóa dữ liệu cho các bước tiếp theo.

- Nền tảng phân tích và Business Intelligence (Trí tuệ doanh nghiệp - BI): Các công cụ BI và phân tích dữ liệu sẽ sử dụng dữ liệu đã qua xử lý để thực hiện phân tích, trực quan hóa và đưa ra các dự đoán, cung cấp thông tin hỗ trợ cho việc ra quyết định và chiến lược kinh doanh hiệu quả.

4. Các phương pháp Data Integration

Data Integration là quá trình kết hợp các nguồn dữ liệu không đồng nhất từ nhiều hệ thống khác nhau để tạo ra một cái nhìn thống nhất về dữ liệu. Việc lựa chọn phương pháp tích hợp phù hợp phụ thuộc vào nhu cầu kỹ thuật và quy mô của tổ chức. Dưới đây là các phương pháp Data Integration phổ biến:

- Sao chép dữ liệu

- Liên kết dữ liệu

- Ảo hóa dữ liệu

- Hợp nhất dữ liệu

4.1. Sao chép dữ liệu

Sao chép dữ liệu là một trong những phương pháp tích hợp cơ bản và đơn giản nhất, bao gồm việc tạo ra bản sao dữ liệu từ một hệ thống nguồn mà không làm thay đổi dữ liệu gốc. Phương pháp này không can thiệp vào cấu trúc dữ liệu ban đầu, giúp dữ liệu được truy cập và xử lý nhanh chóng mà không cần phải thay đổi hệ thống nguồn.

- Ưu điểm: Việc sao chép dữ liệu đảm bảo tính toàn vẹn và không làm gián đoạn các hệ thống nguồn. Nó phù hợp với các doanh nghiệp nhỏ hoặc các tổ chức có ít hệ thống dữ liệu cần tích hợp, giúp tiết kiệm thời gian và tăng hiệu quả khi cần truy cập dữ liệu.

- Nhược điểm: Phương pháp này có thể gặp phải vấn đề đồng bộ hóa dữ liệu, đặc biệt khi dữ liệu thay đổi liên tục hoặc trong môi trường có khối lượng dữ liệu lớn. Ngoài ra, việc duy trì các bản sao có thể gây tốn kém tài nguyên.

Phương pháp sao chép dữ liệu thường được sử dụng khi yêu cầu về hiệu suất cao và truy cập nhanh từ nhiều hệ thống khác nhau mà không cần thay đổi cấu trúc dữ liệu gốc

4.2. Liên kết dữ liệu

Liên kết dữ liệu là phương pháp tạo ra một cơ sở dữ liệu tổng hợp từ nhiều nguồn dữ liệu mà không cần di chuyển hoặc tích hợp vật lý các nguồn dữ liệu này vào một hệ thống chung. Thay vào đó, hệ thống sẽ truy vấn dữ liệu trực tiếp từ các nguồn liên kết, kết hợp chúng tạm thời trong thời gian thực để trả về kết quả mà không sao chép hoặc di chuyển dữ liệu.

- Ưu điểm: Phương pháp này giảm thiểu việc sao lưu và bảo trì dữ liệu, giúp tiết kiệm chi phí lưu trữ. Nó đặc biệt hữu ích trong các hệ thống phân tán nơi các nguồn dữ liệu được lưu trữ ở nhiều nơi khác nhau.

- Nhược điểm: Tuy nhiên, việc liên kết dữ liệu phụ thuộc vào khả năng truy vấn và hiệu suất của các hệ thống nguồn. Khi số lượng nguồn dữ liệu và yêu cầu về truy vấn ngày càng tăng, hệ thống có thể gặp khó khăn trong việc duy trì hiệu quả.

Phương pháp này phù hợp với các tổ chức có yêu cầu truy xuất dữ liệu nhanh từ các hệ thống khác nhau mà không cần phải hợp nhất vật lý các nguồn dữ liệu, đặc biệt là trong các môi trường có nhiều hệ thống phân tán.

4.3. Ảo hóa dữ liệu

Ảo hóa dữ liệu cung cấp một lớp trung gian giữa người dùng và các nguồn dữ liệu phân tán. Khác với phương pháp liên kết dữ liệu, ảo hóa dữ liệu cho phép người dùng truy cập dữ liệu từ nhiều nguồn khác nhau như thể chúng nằm trong một cơ sở dữ liệu duy nhất. Phương pháp này không chỉ đơn giản là truy vấn trực tiếp, mà còn tích hợp các cơ chế tối ưu hóa hiệu suất, như bộ nhớ đệm (caching) và các chiến lược xử lý thông minh để cải thiện tốc độ phản hồi và sự nhất quán của dữ liệu.

- Ưu điểm: Ảo hóa dữ liệu mang lại trải nghiệm nhất quán và hiệu suất cao, giúp người dùng dễ dàng truy cập dữ liệu từ nhiều nguồn mà không cần phải lo lắng về sự khác biệt trong cấu trúc dữ liệu. Điều này giúp tiết kiệm thời gian và tài nguyên, đặc biệt trong các tổ chức lớn với nhu cầu truy cập dữ liệu từ nhiều hệ thống.

- Nhược điểm: Mặc dù ảo hóa dữ liệu giúp đơn giản hóa việc truy cập dữ liệu, nhưng việc quản lý và duy trì lớp ảo hóa có thể trở thành một thách thức nếu số lượng nguồn dữ liệu tăng lên hoặc nếu các hệ thống không tương thích.

Phương pháp này phù hợp với các doanh nghiệp cần truy xuất dữ liệu từ nhiều nguồn mà không muốn thay đổi cấu trúc dữ liệu hoặc di chuyển dữ liệu, đồng thời vẫn đảm bảo tốc độ và hiệu suất.

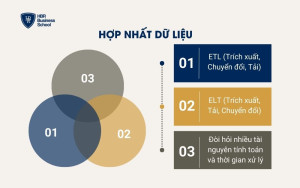

4.4. Hợp nhất dữ liệu

Hợp nhất dữ liệu là phương pháp sử dụng các công cụ tích hợp dữ liệu như ETL (Extract, Transform, Load) và ELT (Extract, Load, Transform) để trích xuất dữ liệu từ nhiều nguồn khác nhau, làm sạch, chuẩn hóa và lưu trữ chúng ở một vị trí duy nhất, thường là kho dữ liệu (data warehouse). Phương pháp này giúp giảm thiểu sự phức tạp trong việc quản lý và phân tích dữ liệu.

- ETL (Trích xuất, Chuyển đổi, Tải): Dữ liệu được trích xuất từ các nguồn khác nhau, chuyển đổi theo các quy tắc đã định sẵn để chuẩn hóa và làm sạch, và sau đó tải vào hệ thống đích (thường là kho dữ liệu). Đây là phương pháp phổ biến khi dữ liệu cần được xử lý trước khi nạp vào hệ thống đích.

- ELT (Trích xuất, Tải, Chuyển đổi): Khác với ETL, phương pháp này tải dữ liệu trực tiếp vào hệ thống đích trước khi thực hiện các bước chuyển đổi. Điều này cho phép sử dụng sức mạnh tính toán của kho dữ liệu và phù hợp với các ứng dụng dữ liệu lớn.

- Ưu điểm: Hợp nhất dữ liệu giúp tạo ra một nguồn dữ liệu duy nhất, làm cho việc phân tích và báo cáo dễ dàng hơn. Phương pháp này đặc biệt hữu ích khi dữ liệu đến từ nhiều nguồn có cấu trúc khác nhau.

- Nhược điểm: Phương pháp này có thể đòi hỏi nhiều tài nguyên tính toán và thời gian xử lý dài đối với các tập dữ liệu lớn, đồng thời yêu cầu duy trì một hệ thống kho dữ liệu mạnh mẽ.

Phương pháp hợp nhất dữ liệu rất phù hợp với các doanh nghiệp cần tích hợp và xử lý dữ liệu từ nhiều nguồn khác nhau để phục vụ cho các nhu cầu phân tích và báo cáo.

5. Vì sao doanh nghiệp cần triển khai Data Integration?

Data Integration (Tích hợp dữ liệu) là yếu tố cốt lõi giúp doanh nghiệp tận dụng tối đa tài nguyên dữ liệu hiện có. Khi dữ liệu được tích hợp từ nhiều nguồn khác nhau, nó không chỉ mang lại cái nhìn thống nhất và chi tiết về hoạt động kinh doanh, mà còn giúp cải thiện quyết định, tối ưu hóa quy trình, và tăng trưởng bền vững.

Dưới đây là những lý do quan trọng mà doanh nghiệp cần triển khai Data Integration để đạt được hiệu quả tối ưu.

- Cái nhìn toàn diện về hoạt động kinh doanh: Tích hợp dữ liệu từ nhiều nguồn giúp tạo ra cái nhìn tổng thể về mọi khía cạnh trong doanh nghiệp, từ hoạt động tài chính đến hiệu suất bán hàng. Điều này giúp lãnh đạo đưa ra quyết định chính xác và kịp thời, giảm thiểu rủi ro và tăng trưởng hiệu quả.

- Tối ưu hóa quy trình làm việc: Tích hợp dữ liệu tự động giúp loại bỏ công việc thủ công tốn thời gian và các lỗi phát sinh, từ đó nâng cao hiệu quả công việc và tối ưu hóa nguồn lực trong tổ chức.

- Đảm bảo tính đồng nhất và chính xác: Việc hợp nhất dữ liệu từ các hệ thống khác nhau đảm bảo rằng tất cả các bộ phận trong doanh nghiệp sử dụng thông tin chính xác và nhất quán, xây dựng niềm tin vào dữ liệu phục vụ cho các chiến lược dài hạn.

- Hiểu rõ hành vi và sở thích của khách hàng: Kết hợp dữ liệu từ nhiều điểm tiếp xúc giúp doanh nghiệp phân tích hành vi khách hàng, từ đó cung cấp các dịch vụ và sản phẩm cá nhân hóa, gia tăng sự hài lòng và lòng trung thành từ khách hàng.

- Nhanh chóng nhận diện xu hướng thị trường: Với Data Integration, doanh nghiệp có thể phát hiện xu hướng thị trường và cơ hội mới nhanh chóng, giúp duy trì vị thế cạnh tranh trong ngành và nắm bắt cơ hội trước đối thủ.

Data Integration không chỉ giúp tối ưu hóa quy trình, mà còn là nền tảng vững chắc giúp doanh nghiệp ra quyết định chính xác, tăng cường hiệu quả hoạt động và hiểu rõ hành vi khách hàng, từ đó thúc đẩy sự tăng trưởng và thành công bền vững. Những lợi ích này đóng vai trò quan trọng trong việc duy trì sự cạnh tranh và phát triển lâu dài.

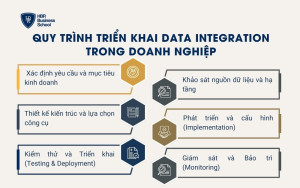

6. Quy trình triển khai Data Integration trong doanh nghiệp

Quy trình triển khai Data Integration trong doanh nghiệp là một chuỗi các bước quan trọng nhằm kết nối và hợp nhất dữ liệu từ nhiều nguồn khác nhau vào một hệ thống duy nhất. Quá trình này giúp doanh nghiệp tối ưu hóa việc sử dụng dữ liệu, từ đó hỗ trợ ra quyết định chính xác và thúc đẩy hiệu quả hoạt động kinh doanh.

6.1. Xác định yêu cầu và mục tiêu kinh doanh

Trước khi triển khai một hệ thống Data Integration hiệu quả, việc xác định rõ yêu cầu và mục tiêu kinh doanh là bước đầu tiên vô cùng quan trọng. Mục tiêu này sẽ giúp doanh nghiệp hiểu được lý do tại sao dữ liệu cần phải được tích hợp, từ đó có thể định hướng chính xác các chiến lược triển khai.

Mục đích có thể là để phân tích dự báo bằng AI, tạo báo cáo BI, hay đồng bộ hóa hệ thống CRM/ERP. Khi các mục tiêu rõ ràng, doanh nghiệp sẽ dễ dàng hơn trong việc lựa chọn công cụ, thiết lập các chỉ số KPI cần theo dõi và tối ưu hóa tài nguyên triển khai.

- Xác định mục đích sử dụng dữ liệu: Doanh nghiệp cần hiểu rõ mục tiêu tích hợp dữ liệu là gì: hệ thống báo cáo, phân tích dữ liệu cho dự báo, hay đồng bộ hóa các hệ thống nội bộ như CRM/ERP.

- Xác định các chỉ số KPI cần theo dõi: Việc này giúp doanh nghiệp đo lường hiệu quả của quá trình tích hợp và đảm bảo rằng dữ liệu được sử dụng đúng mục đích.

- Định rõ phạm vi dữ liệu cần tích hợp: Việc này sẽ giúp xác định tính toàn vẹn và chất lượng dữ liệu cần thiết trong quá trình tích hợp.

- Dự tính chi phí và tài nguyên: Một kế hoạch rõ ràng sẽ giúp tối ưu hóa chi phí triển khai, tránh lãng phí và tiết kiệm thời gian.

- Phân tích nhu cầu trong dài hạn: Cần xác định rõ liệu Data Integration chỉ phục vụ nhu cầu ngắn hạn hay cần một giải pháp lâu dài để mở rộng và thích ứng với nhu cầu tương lai.

6.2. Khảo sát nguồn dữ liệu và hạ tầng

Sau khi xác định yêu cầu và mục tiêu kinh doanh, bước tiếp theo là khảo sát các nguồn dữ liệu hiện có. Việc kiểm kê các nguồn dữ liệu sẽ giúp doanh nghiệp hiểu rõ nguồn gốc và tính chất của từng loại dữ liệu đang sử dụng.

Các nguồn này có thể là SaaS, cơ sở dữ liệu on-premise, file phẳng, API, hoặc các dữ liệu không cấu trúc từ nhiều hệ thống khác nhau. Bước này cũng bao gồm việc đánh giá chất lượng dữ liệu và lựa chọn kiến trúc tích hợp phù hợp.

- Kiểm kê tất cả các nguồn dữ liệu hiện có: Doanh nghiệp cần xác định tất cả các nguồn dữ liệu đang có để đảm bảo tính đầy đủ của dữ liệu tích hợp.

- Đánh giá chất lượng dữ liệu: Kiểm tra xem các nguồn dữ liệu có đảm bảo độ chính xác và tính nhất quán không, đặc biệt là dữ liệu không cấu trúc hoặc không đồng nhất.

- Lựa chọn phương pháp tích hợp phù hợp: ETL (Extract, Transform, Load) cho dữ liệu truyền thống hoặc ELT (Extract, Load, Transform) cho các nền tảng đám mây hiện đại như Snowflake và Google BigQuery.

- Chọn lựa kiến trúc phù hợp với hạ tầng công nghệ: Cần quyết định sử dụng kiến trúc đám mây hay on-premise tùy vào yêu cầu về bảo mật và khả năng mở rộng.

- Đánh giá tính tương thích của công nghệ: Đảm bảo các công cụ và nền tảng tích hợp có thể hoạt động hiệu quả trên hệ thống hiện tại của doanh nghiệp.

6.3. Thiết kế kiến trúc và lựa chọn công cụ

Thiết kế kiến trúc tích hợp là bước quan trọng để xây dựng dòng chảy dữ liệu (Data Flow) trong hệ thống tích hợp. Doanh nghiệp cần lựa chọn các công cụ phù hợp, từ công cụ low-code/no-code đến công cụ dành cho doanh nghiệp. Việc lựa chọn công cụ sẽ ảnh hưởng đến hiệu quả triển khai, khả năng mở rộng và bảo trì của hệ thống dữ liệu.

Đảm bảo rằng công cụ được chọn phù hợp với ngân sách và trình độ kỹ thuật của đội ngũ là rất quan trọng.

- Xây dựng sơ đồ dòng chảy dữ liệu: Thiết kế cách thức dữ liệu sẽ di chuyển từ các nguồn đến hệ thống đích, đảm bảo rằng quá trình tích hợp được thực hiện một cách mạch lạc và hiệu quả.

- Lựa chọn công cụ tích hợp phù hợp: Các công cụ như Fivetran, Airbyte cho các dự án nhỏ, hoặc Informatica, Talend cho các hệ thống doanh nghiệp lớn cần được lựa chọn dựa trên quy mô và tính chất của dự án.

- Đảm bảo khả năng mở rộng của công cụ: Công cụ tích hợp cần có khả năng mở rộng và xử lý khối lượng dữ liệu lớn khi doanh nghiệp phát triển.

- Chọn công cụ hỗ trợ tích hợp đám mây: Các công cụ như Snowflake hoặc Google BigQuery giúp tối ưu hóa việc lưu trữ và xử lý dữ liệu trên nền tảng đám mây.

- Phân tích chi phí và lợi ích: Cần đánh giá các công cụ về chi phí, tính dễ sử dụng và khả năng hỗ trợ để chọn được công cụ phù hợp nhất với ngân sách và nhu cầu doanh nghiệp.

6.4. Phát triển và cấu hình (Implementation)

Giai đoạn phát triển và cấu hình là bước thực hiện các công việc kỹ thuật cần thiết để kết nối các nguồn dữ liệu và hệ thống đích. Các công đoạn này bao gồm thiết lập các đường dẫn dữ liệu (Data Pipelines), chuẩn hóa định dạng, xử lý dữ liệu trùng lặp và làm sạch dữ liệu. Đồng thời, bảo mật và mã hóa dữ liệu cũng là yếu tố quan trọng để bảo vệ dữ liệu trong quá trình tích hợp.

- Thiết lập Data Pipelines: Xây dựng các luồng dữ liệu để kết nối và chuyển đổi dữ liệu từ hệ thống nguồn đến hệ thống đích.

- Chuẩn hóa định dạng dữ liệu: Đảm bảo rằng các dữ liệu từ nhiều nguồn có thể tương thích với nhau khi nạp vào hệ thống đích.

- Xử lý dữ liệu trùng lặp và làm sạch dữ liệu: Loại bỏ các dữ liệu dư thừa và không chính xác để đảm bảo chất lượng dữ liệu trong hệ thống.

- Thiết lập quy tắc bảo mật và mã hóa: Bảo vệ dữ liệu bằng các biện pháp mã hóa và kiểm soát truy cập theo tiêu chuẩn như GDPR hoặc ISO 27001.

- Kiểm tra tính toàn vẹn dữ liệu: Đảm bảo rằng dữ liệu đã được chuyển đổi và nạp chính xác mà không bị lỗi.

6.5. Kiểm thử và Triển khai (Testing & Deployment)

Giai đoạn kiểm thử và triển khai bao gồm việc kiểm thử dữ liệu để đảm bảo tính toàn vẹn và chính xác trước khi triển khai chính thức trên môi trường production. Doanh nghiệp cần thực hiện các kiểm thử đơn vị (unit testing) cho từng pipeline và kiểm thử hệ thống để đảm bảo mọi thứ hoạt động như mong đợi.

- Kiểm thử đơn vị (Unit Testing): Kiểm tra từng pipeline riêng biệt để đảm bảo rằng dữ liệu được xử lý đúng.

- Kiểm thử hệ thống: Kiểm tra tính chính xác và thời gian phản hồi của toàn bộ hệ thống, đảm bảo rằng dữ liệu có thể được nạp và truy xuất chính xác.

- Kiểm tra tính toàn vẹn của dữ liệu: Đảm bảo rằng các dữ liệu tải về từ các nguồn vẫn giữ được tính toàn vẹn và không bị mất mát.

- Tiến hành triển khai chính thức: Sau khi hoàn thành các kiểm thử, triển khai hệ thống trên môi trường production để sử dụng chính thức.

- Kiểm tra tính sẵn sàng của hệ thống: Đảm bảo rằng hệ thống có thể hoạt động liên tục mà không gặp sự cố.

6.6. Giám sát và Bảo trì (Monitoring)

Sau khi hệ thống được triển khai, việc giám sát liên tục là rất quan trọng để phát hiện và khắc phục các vấn đề kịp thời. Sử dụng các công cụ giám sát để phát hiện lỗi pipeline, đảm bảo rằng hệ thống luôn được cập nhật và đồng bộ hóa khi có thay đổi trong nguồn dữ liệu.

Bên cạnh đó, bảo trì định kỳ sẽ giúp hệ thống hoạt động hiệu quả và phù hợp với nhu cầu thay đổi của doanh nghiệp.

- Sử dụng công cụ giám sát để theo dõi các pipeline và phát hiện lỗi ngay lập tức.

- Cập nhật kết nối khi nguồn dữ liệu thay đổi API hoặc cấu trúc.

- Đánh giá chất lượng dữ liệu định kỳ để duy trì tính chính xác của dữ liệu phục vụ cho các mô hình học máy (Machine Learning).

- Đảm bảo tính sẵn sàng của hệ thống: Đảm bảo rằng hệ thống luôn sẵn sàng và đáp ứng nhanh chóng với các yêu cầu phân tích dữ liệu.

- Thực hiện bảo trì và tối ưu hóa hệ thống theo chu kỳ để giữ cho hệ thống hoạt động ổn định và hiệu quả.

7. Thách thức khi triển khai Data Integration

Mặc dù Data Integration mang lại nhiều lợi ích cho doanh nghiệp, nhưng quá trình triển khai không phải lúc nào cũng dễ dàng. Việc kết hợp dữ liệu từ các nguồn khác nhau có thể gặp phải không ít thách thức lớn, ảnh hưởng đến tiến độ và hiệu quả triển khai. Dưới đây là những thách thức chính mà doanh nghiệp cần đối mặt khi triển khai Data Integration.

- Khó khăn khi tích hợp dữ liệu từ nhiều nguồn khác nhau: Các nguồn dữ liệu có thể có cấu trúc, định dạng, và tiêu chuẩn chất lượng khác nhau, điều này làm tăng độ phức tạp của quá trình tích hợp và có thể dẫn đến sự chậm trễ và tăng chi phí cho doanh nghiệp.

- Ngữ nghĩa dữ liệu không đồng nhất: Ngữ nghĩa dữ liệu thay đổi tùy theo nguồn và có thể gây ra sự hiểu sai trong quá trình tích hợp. Các trường dữ liệu có thể đại diện cho các khái niệm khác nhau, làm cho việc đồng bộ hóa và ánh xạ dữ liệu trở nên khó khăn hơn.

- Tích hợp hệ thống kế thừa gặp nhiều hạn chế: Các hệ thống kế thừa thường thiếu khả năng tương thích với các phương pháp tích hợp hiện đại. Chúng có thể thiếu API hoặc sử dụng định dạng cũ, gây khó khăn trong việc kết nối và chuyển đổi dữ liệu từ hệ thống cũ sang hệ thống mới.

- Áp lực từ nhu cầu xử lý dữ liệu ngày càng cao: Khi khối lượng dữ liệu ngày càng tăng, hệ thống cần có khả năng mở rộng để xử lý và tích hợp dữ liệu lớn. Nếu không có hạ tầng phù hợp, việc tích hợp dữ liệu có thể gây tắc nghẽn và ảnh hưởng đến hiệu suất chung của tổ chức.

- Bảo mật và tuân thủ quy định dữ liệu: Việc tích hợp dữ liệu nhạy cảm từ nhiều nguồn khác nhau yêu cầu phải đảm bảo an ninh thông tin và tuân thủ các quy định bảo mật. Các biện pháp bảo vệ dữ liệu phải được triển khai đúng cách để ngăn ngừa rủi ro bảo mật và vi phạm quyền riêng tư.

Quá trình Data Integration đóng vai trò quan trọng trong việc tối ưu hóa dữ liệu và nâng cao hiệu quả hoạt động của doanh nghiệp. Mặc dù có nhiều thách thức, từ việc xử lý dữ liệu không đồng nhất đến việc tích hợp hệ thống kế thừa, việc triển khai một chiến lược tích hợp dữ liệu hiệu quả sẽ giúp doanh nghiệp tăng trưởng bền vững, cải thiện khả năng ra quyết định và duy trì vị thế cạnh tranh.

Data Integration là gì

Data Integration (Tích hợp Dữ liệu) là một quá trình quan trọng trong quản lý dữ liệu, liên quan đến việc kết hợp và làm cho các dữ liệu không đồng nhất từ nhiều nguồn khác nhau trở nên thống nhất trong một hệ thống chung.